Es el momento de preguntarse… ¿nos traerá la singularidad tecnológica solo una explosión de inteligencia artificial? ¿o nos traerá también una explosión de consciencia artificial? Porque no es lo mismo ser inteligente (sapiencia) que ser conscientes (sintiencia). Como vimos en la entrada “¿Zombis o fantasmas?” el hecho de que pueda surgir consciencia en una inteligencia artificial es un tema poco consensuado por la comunidad científica y filosófica.

En 1950, el matemático Alan Turing propuso el “Test de Turing” para averiguar si una máquina podía hacerse pasar por un humano. Para ello ideó una prueba donde una persona realizaba preguntas, mediante un teclado y un monitor, a los participantes en la misma, entre los que se encontraba una máquina. Si el interrogador no era capaz de averiguar por las respuestas dadas, cual de ellos era la máquina, en 5 minutos de conversación, ésta había pasado la prueba, aunque no por ello significaba que fuera capaz tener pensamientos conscientes.

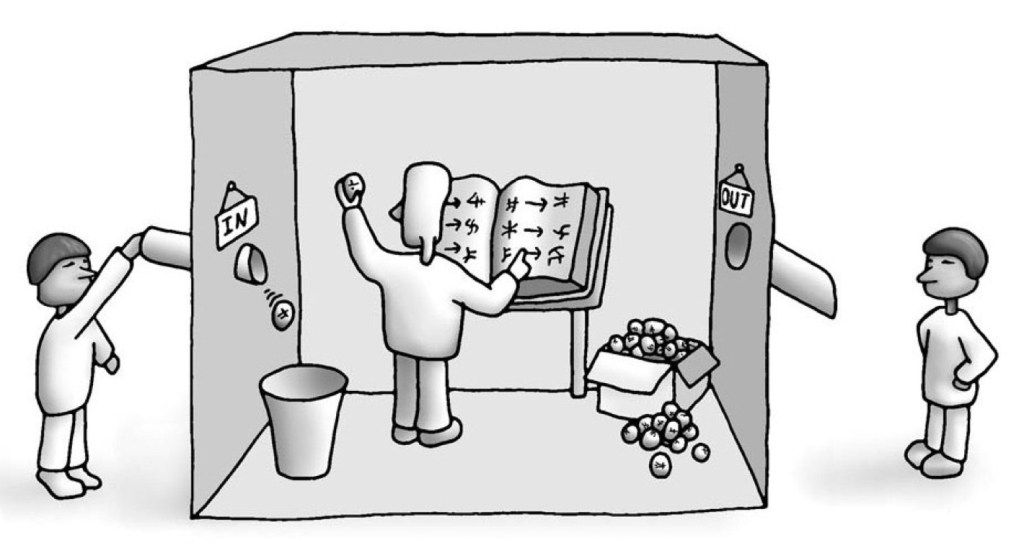

En 1980, el filósofo John Searle planteó un experimento mental denominado “La habitación china” donde una máquina era aparentemente capaz de comprender el chino, de manera que si recibía un texto en este idioma respondía con una respuesta coherente, es decir, que podría pasar el test de Turing, pus convencería a un chino de que entendía su idioma. Searle propuso sustituir la máquina por una persona encerrada en una habitación que no conociera el idioma chino, pero que estuviera rodeado de libros con las reglas para relacionar los caracteres con los que debía enviar de respuesta. De esta manera, podía hacer creer al chino que antes interrogaba a la máquina, que él también conocía su idioma, aunque en realidad no tenía ni idea del mismo. La cuestión era que, si esta persona sin entender chino, podía hacerle creer que lo entendía, de igual modo una computadora podía hacerle creer lo mismo, sin necesidad de entenderlo, pues ambos, ordenador y persona, utilizaban unas reglas para manipular los símbolos y dar una respuesta; el primero un programa y, el segundo, libros y manuales en chino.

Los defensores de la superinteligencia artificial creen que éstas pueden tener mente. Searle con este experimento niega esta idea, porque para el ordenador los símbolos no tienen significado y las máquinas no tienen consciencia de sí mismas. Los pensamientos de las personas no solo son símbolos (sintaxis) también poseen un contenido. Por ejemplo, yo pienso que huelo una flor, mientras que un ordenador tan solo posee sintaxis. Por tanto, poseer un programa no es suficiente para que un ordenador posea una mente.

¿Podríamos averiguar de alguna forma si existe o no consciencia en un sistema inteligente?

Una teoría que puede ayudar a resolver este problema viene de la mano del neurocientífico Giulio Tononi. Se denomina “Teoría integrada de la Información (ITT)” y su objetivo es conocer si un sistema es consciente y en qué grado lo es. Resulta casi anti-intuitivo creer que, para determinar el grado de conciencia de algo, no hace falta que esté compuesto de material biológico, tan solo hace falta que posea… información.

Según la ITT, las características de un estado consciente son: información, unidad y escala espacio-temporal. La información se refiere a que el sistema puede ser consciente de muchas cosas de forma diferenciada. Por ejemplo, puede tener acceso a la información de colores, formas o sonidos. La unidad implica que esa información se recibe de forma completa. Por ejemplo, no se puede separar la información del color por un lado y la de la información de la forma por otro, ambas se experimentan a la vez de forma integrada. Respecto a la escala espacio-temporal se refiere a que la consciencia fluye a una velocidad determinada. Se necesita entre 100 y 200 milisegundos para tener una experiencia sensorial.

Tononi nos compara el cerebro humano con una red de fotodiodos. Un fotodiodo es un conductor sensible a la luz que solo puede diferenciar dos tipos de información: cuando la luz está encendida o apagada, pero nada más, no puede distinguir más información sobre la luz. Una cámara digital con un millón de fotodiodos podría distinguir un gran número de estados (2 elevado a un millón de estados), sin embargo, esto no la dota de conciencia porque los fotodiodos son independientes entre sí, no aportan una información conjunta (integrada). En cambio, en el cerebro humano todos los estados son dependientes unos de otros.

Por ejemplo, cuando vemos una imagen se experimenta de forma completa y no como un conjunto de imágenes independientes, no podemos separar la información que nos llega del campo visual izquierdo del derecho. Por tanto, un sistema físico deberá ser capaz de generar consciencia si posee información diferenciada e integrada.

¿Y cómo se puede medir la consciencia de un sistema?

Pues al igual que la información en un archivo digital se mide en bits, esta teoría utiliza una unidad de medida denominada phi (Φ) que equivale a la cantidad de información integrada que contiene. Si la información del sistema le viene dada por la suma de sus partes, es decir, que se puede dividir en unidades más pequeñas entonces, Φ será menor que cero. Si, por el contrario, el sistema es más que la suma de sus partes, entonces Φ será mayor que cero. El cerebro humano con muchas neuronas y muchas conexiones tendrá un phi muy alto y será más bajo si está dormido o anestesiado.

Phi, no se mide en términos físicos, como los amperios o los julios, sino matemáticamente, y da cuenta de una cantidad de información integrada que no podría generarse si el sistema estuviera separado en partes. Para averiguarla, no es necesario analizar estrictamente las redes neuronales, pues no todos los sistemas las poseen, sino la organización y la interacción de sus componentes y cómo la información fluye y se integra a través de ellos.

Por tanto, la IIT tan solo exige que un sistema tenga un cierto nivel de integración (phi diferente a cero) para que pueda tener algún grado de conciencia. No se trata de un todo o nada, sino que es gradual. Los sistemas formados por elementos simples tendrán experiencias simples y los complejos como nuestro cerebro la tendrán experiencias muy ricas. El problema de llevar a cabo los algoritmos de IIT es que se necesita una computación muy potente por la gran cantidad de cálculos que genera.

Sería muy interesante que algún día se llegara a desarrollar una teoría sobre la consciencia. No solo serviría para detectarla en las inteligencias artificiales del futuro, sino también en los seres vivos, para determinar su grado de consciencia y que los médicos pudieran reconocer mejor el sufrimiento de sus pacientes.

Puedes ver esta entrada en Youtube

¡¡¡No te la pierdas!!!

Referencias